Простыми словами: что такое майнинг и куда делиcь все видеокарты

Вы наверняка слышали из новостей, что из продажи пропали все видеокарты. Вы даже узнали оттуда, кто все скупил — майнеры. Они «майнят» криптовалюту на своих «фермах». Уверен, что вы слышали про самую известную криптовалюту — Биткойн.

Но еще я полагаю, что вы не очень понимаете, почему это началось именно сейчас, в чем конкретно состоит этот самый майнинг и почему вообще так много шума вокруг каких-то странных «электронных фантиков». Может, если все занялись майнингом, то и вам надо? Давайте разберемся в сути происходящего.

Блокчейн

Для начала немного основ биткойна и блокчейна. Подробнее вы можете почитать об этом в другой нашей статье, а тут я напишу совсем коротко.

Биткойн — децентрализованные виртуальные деньги. То есть нет какого-то центрального органа, никто не доверяет никому, но тем не менее можно безопасно организовать платежи. Помогает в этом блокчейн.

«Технология блокчейн, на мой взгляд, — это новый интернет. Это идея такого же уровня, как интернет.«

— Герман Греф

Блокчейн — это такой интернет-дневник. Блокчейн представляет собой последовательную цепочку блоков, в каждом из которых записаны транзакции: кто и кому сколько биткойнов перевел. На английском его еще называют ledger — буквально «гроссбух». Собственно, гроссбух и есть — но с парой важных особенностей.

Первая ключевая особенность блокчейна — все полноценные участники сети Биткойн хранят всю цепочку блоков со всеми транзакциями за все время. И постоянно дописывают в конец новые блоки. Повторю, весь блокчейн у каждого пользователя хранится целиком — и он точно такой же, как у всех остальных участников.

Второй ключевой момент: блокчейн основан на криптографии (отсюда и «крипто» в слове криптовалюта). Правильная работа системы гарантирована математикой, а не репутацией какого-то человека или организации.

Те, кто создают новые блоки, называются майнерами. В награду за каждый новый блок его создатель сейчас получает 12,5 биткойнов. По курсу на 1.07.2017 — это примерно $30 000. Чуть позже мы поговорим об этом подробнее.

Кстати, награды за создание блоков — это единственный способ эмиссии биткойна. То есть все новые биткойны создаются именно с помощью майнинга.

Новый блок создаётся только раз в 10 минут. На это есть две причины.

Во-первых, сделано это для стабильной синхронизации — чтобы за 10 минут успеть распространить блок по всему интернету. Если бы блоки создавались непрерывно всеми желающими, то интернет был бы заполонен разными версиями, и было бы сложно понять, какую из этих версий все должны в итоге дописать в конец блокчейна.

Во-вторых, эти 10 минут тратятся на то, чтобы сделать новый блок «красивым» с математической точки зрения. Только правильный и только красивый блок дописывается в конец дневника-блокчейна.

Почему блоки должны быть «красивыми»

Правильный блок — это значит, что в нем все верно, все по правилам. Основное правило: тот, кто передает деньги, действительно имеет столько денег.

А красивый блок — это такой, свертка от которого имеет много нулей в начале. Подробнее о том, что такое свертка (или «хэш» — результат некоего математического преобразования блока) вы опять-таки можете вспомнить отсюда. Но для нас сейчас это совершенно непринципиально. Важно то, что для получения красивого блока его нужно «трясти». «Трясти» означает незначительно менять блок — а потом проверять, а не стал ли он вдруг красивым.

Каждый майнер непрерывно «трясёт» блоки-кандидаты и надеется, что именно ему повезет первому «натрясти» красивый блок, который и будет включен в конец блокчейна, — а значит, именно этот майнер получит награду в $30 000.

При этом, если вдруг майнеров станет в десять раз больше, то блокчейн автоматически потребует, что для признания нового блока достойным записи в блокчейн он теперь должен быть в десять раз «красивее». Тем самым скорость появления новых блоков сохранится — будет появляться все равно один блок раз в 10 минут. А вот вероятность какого-то конкретного майнера получить награду уменьшится в 10 раз.

Теперь мы готовы ответить на вопрос, зачем же блоки должны быть красивыми. Это сделано для того, чтобы какой-нибудь условный Вася не мог взять и просто переписать всю историю транзакций.

У Васи не выйдет заявить: «Нет, не отправлял я Мише 10 биткоинов, в моем варианте истории нет такого — верьте мне». Ведь в этом поддельном варианте истории блоки обязаны быть красивыми, а как мы знаем, чтобы натрясти хотя бы один такой блок, надо, чтобы все майнеры работали целых 10 минут, куда уж одному Васе справиться.

Майнеры

Концепция понятна, теперь давайте повнимательнее посмотрим на майнеров.

В 2009 году, когда о Биткойне знали только энтузиасты (или скорее даже только его создатели) и стоил он по пять центов за штуку, майнить было легко. Майнеров было немного, допустим, сто. А значит, в среднем за сутки условному майнеру Иннокентию хоть раз выпадала удача натрясти блок и получить награду.

К 2013 году, когда курс Биткойна подрос до сотни долларов за штуку, энтузиастов-майнеров было уже столько, что ждать удачи пришлось бы месяцами. Майнеры стали объединяться в «пулы». Это такие картели, которые трясут один и тот же блок-кандидат все вместе, а потом делят награду на всех по справедливости (пропорционально затраченным усилиям).

Потом появились специальные устройства — ASIC. Это такие микросхемы, которые созданы специально для выполнения конкретной задачи. В данном случае «асики» узко заточены под то, чтобы как можно более эффективно «трясти» блоки Биткойна.

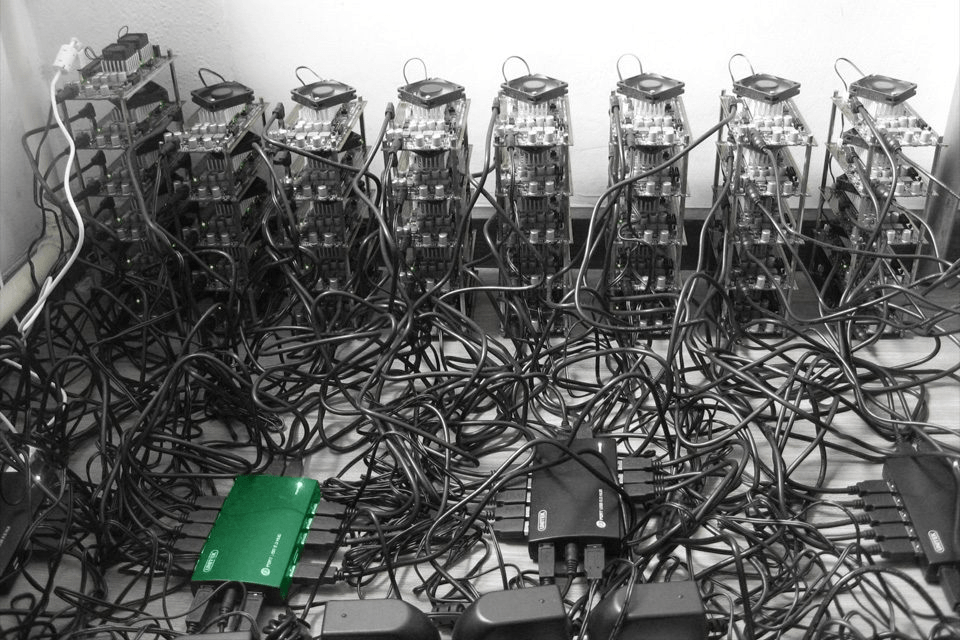

Майнинг-мощность «асиков» несопоставимо больше мощности обычного компьютера, который умеет выполнять любые расчеты. В Китае, Исландии, Сингапуре и других странах стали строить огромные «фермы» из систем на ASIC. Выгодно расположить ферму в шахте под землей, потому что там холодно. Еще выгоднее рядом построить ГЭС, чтобы электричество было дешевле.

Итогом этой гонки вооружений стало то, что майнить именно биткойны в домашних условиях стало совершенно неоправданно.

Майнинг альткоинов или почему видеокарты пропали именно сейчас

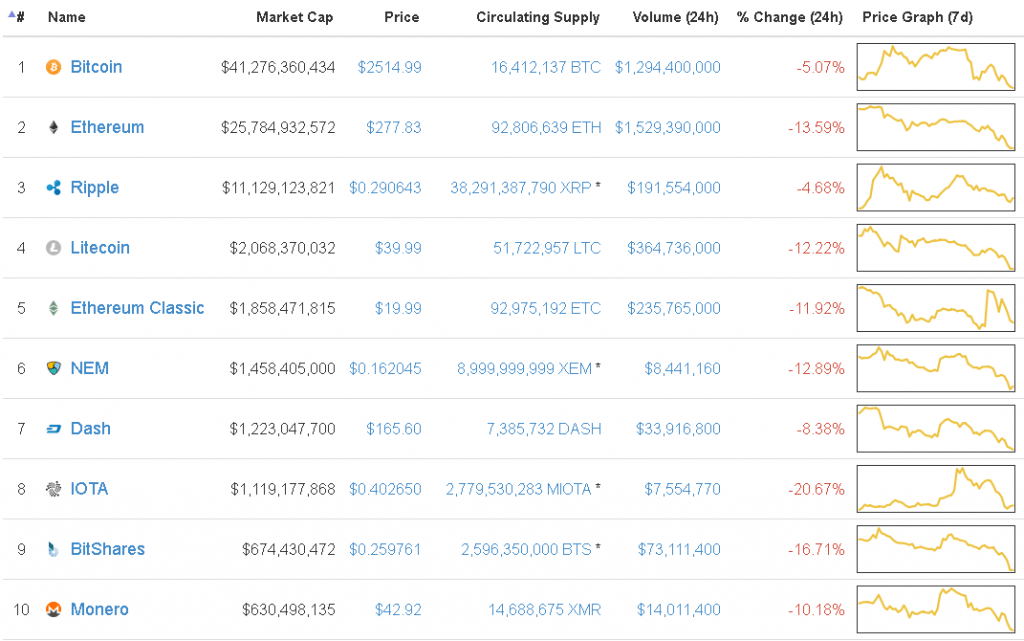

Биткойн — первая и самая популярная криптовалюта. Но с приходом популярности криптовалют как явления как грибы стали появляться конкуренты. Сейчас существует порядка сотни альтернативных криптовалют — так называемых альткоинов.

Каждый создатель альткоина не хочет, чтобы майнить его монетки было сразу очень сложно и дорого, поэтому он придумывает новые критерии красоты блоков. Желательно такие, чтобы создание специализированных устройств (ASIC) было затруднено или максимально отсрочено.

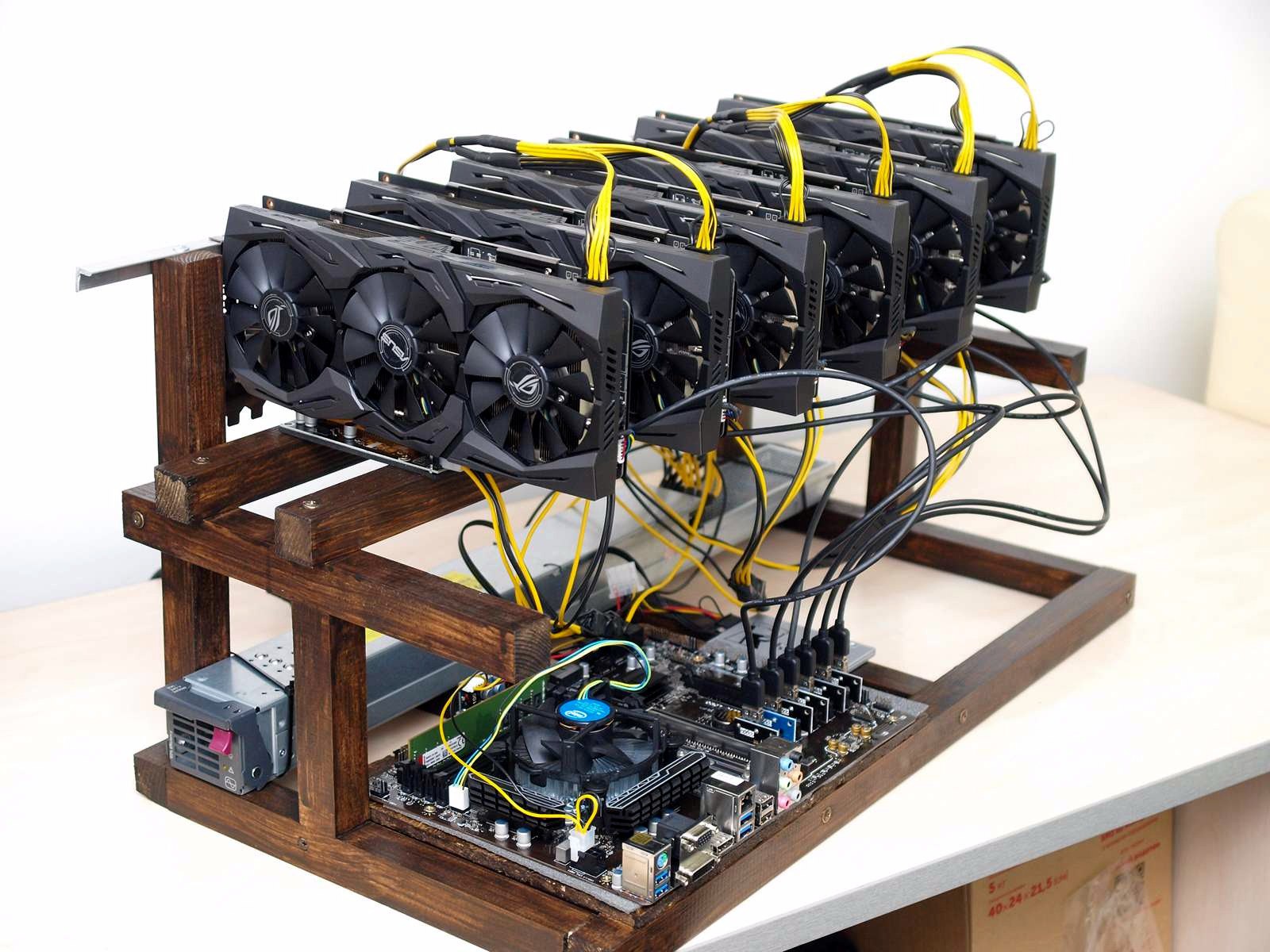

Все делается для того, чтобы любой фанат этого альткоина мог взять свой обычный компьютер, вносить ощутимый вклад в суммарную мощность сети и получать награду. Для «тряски» при этом используется обычная видеокарта — так уж вышло, что видеокарты хорошо подходят для подобных вычислений. Таким образом при помощи доступности процесса майнинга можно увеличить популярность этого альткоина.

Обратите внимание на вторую строчку в таблице выше — Ethereum. Это сравнительно новая криптовалюта (появилась в 2015 году), но с особыми возможностями. Если коротко, то главное нововведение Ethеreum — возможность включать в блокчейн не только статичную информацию о проведенных платежах, но и интерактивные объекты — смарт-контракты, — которые работают по запрограммированным правилам.

Почему это создало такой ажиотаж мы поговорим в отдельной статье. Пока будет достаточно сказать, что новые свойства Ethereum обеспечили большой интерес «криптоивесторов» и, как следствие, бурный рост ее биржевой цены. Если на начало 2017 года один «эфир» стоил $8, то уже к 1 июня курс пробил отметку в $200.

Майнить именно Ethereum стало особенно выгодно, поэтому майнеры и скупили видеокарты.

Видеокарта Gigabyte специально для майнинга — сразу без всяких ненужных вещей вроде выхода на монитор.

Источник

Что будет, если майнеры перестанут майнить

Предположим, что майнить стало невыгодно (прибыль не окупает затраты на оборудование и электричество), и майнеры перестают майнить или начинают майнить какую-то другую валюту. Что тогда? Правда ли, что если майнеры перестанут майнить, то Биткойн перестанет работать или будет работать слишком медленно?

Нет. Как мы с вами выяснили выше, блокчейн постоянно адаптирует критерии «красоты» создаваемых блоков, чтобы в среднем скорость их создания была постоянной. Если будет в 10 раз меньше майнеров, новый блок придется «трясти» в 10 раз меньше, но сам блокчейн при этом будет полностью исполнять свои функции.

Пока рост биржевого курса с лихвой компенсирует падение награды, но когда-нибудь основная прибыль будет поступать с комиссий за переводы, которые тоже забирает себе майнер. Без работы и без награды они не останутся.

Заключение

Мы разобрались, что же на самом деле из себя представляет майнинг, зачем он нужен, кому и когда выгодно майнить, куда из магазинов пропали все видеокарты, и почему некоторые производители теперь выпускают видеокарты сразу без выхода на монитор.

Материал был взят с сайта: https://blog.kaspersky.ru/

Видеокарта Gigabyte специально для майнинга — сразу без всяких ненужных вещей вроде выхода на монитор.

Видеокарта Gigabyte специально для майнинга — сразу без всяких ненужных вещей вроде выхода на монитор.